Introduction à l'IA générative

Parler d’intelligence artificielle (IA) induit le biais de se représenter l’intelligence selon notre perception humaine de ce qu’elle peut être. Ses contours sont mal définis, mais nous nous accordons généralement pour en avoir une idée commune qui se rapporte à notre capacité à effectuer certaines tâches avec un certain degré de compétence. L’analogie informatique par l’ajout du qualificatif «artificielle» ne permet pas de comprendre ce qu’est une IA, ni ce qu’elle peut faire, car elle ne partage pas la même cartographie de compétences.

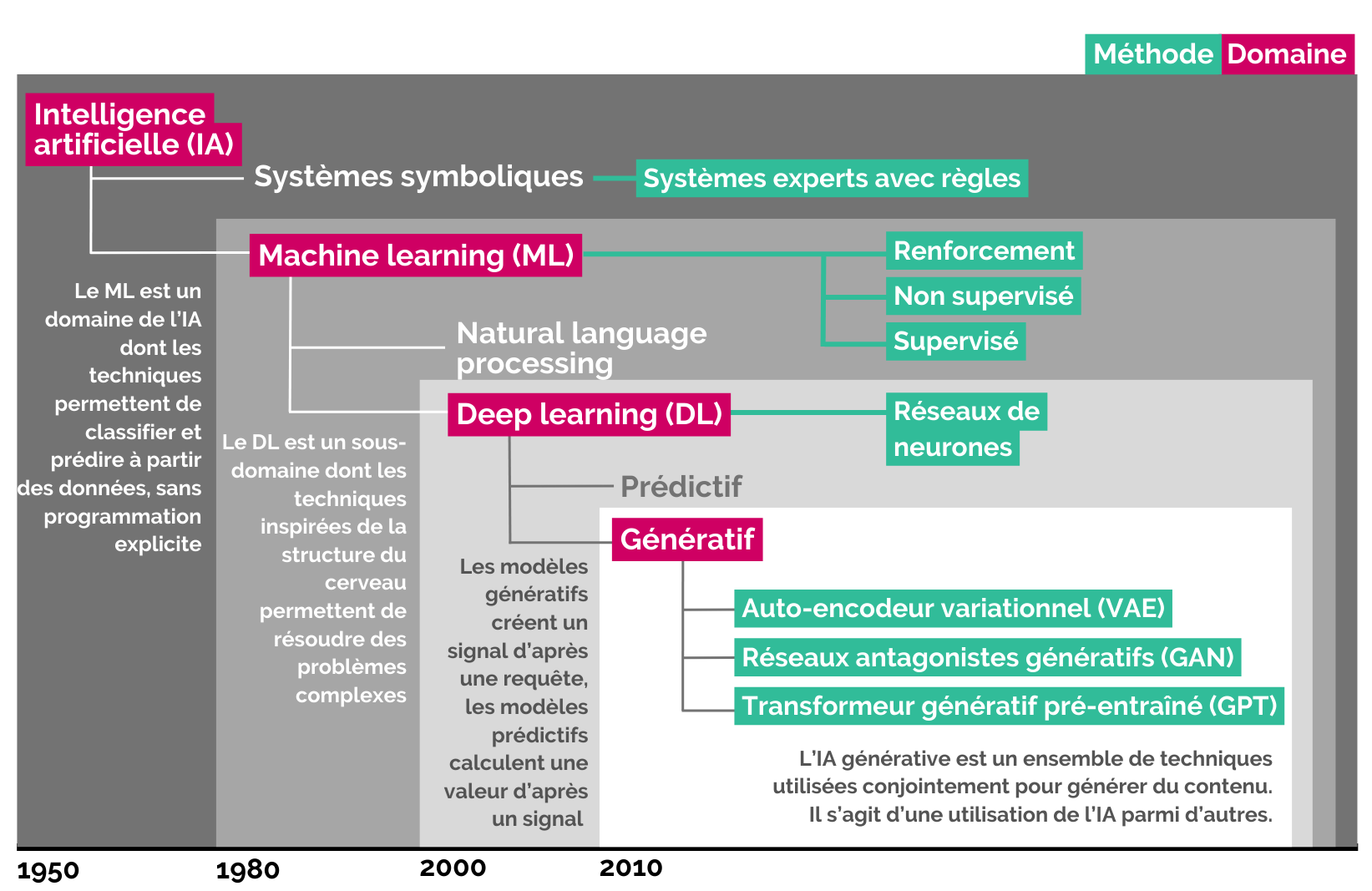

L'intelligence artificielle désigne un domaine informatique. Les technologies qu’il englobe, souvent utilisées en combinaison, permettent aux ordinateurs d’exécuter un certain nombre de tâches spécialisées. Sa particularité principale, comparativement à un programme informatique classique, est l’autonomie de l’IA. Elle est conçue pour apprendre et s’améliorer avec le temps, elle peut effectuer un raisonnement, mais aussi percevoir des stimuli externes et interagir avec son environnement. Pour ces raisons, une IA est capable de réaliser un certain nombre de tâches complexes, habituellement propres à l’être humain, et généralement associées à notre conception de l’intelligence.

L’IA n’est pas nouvelle. Le domaine comprend plusieurs technologies différentes, dont certaines existent depuis des années ou des décennies (voir chronologie ci-contre).

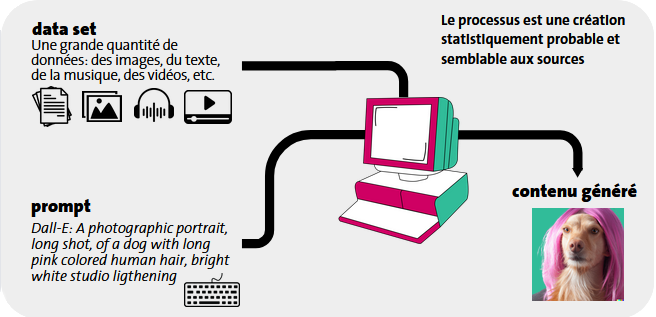

Ce que l’on entend par le terme de «générative» est la capacité de l’IA à créer de l’information de manière automatique à partir de grands volumes de données existantes sur lesquelles elle est entraînée. L’IA ne fait pas de simple copier-coller de ce qu’elle a analysé: elle imite, améliore et crée un résultat entièrement nouveau, basé sur une recomposition statistique des motifs et structures qu’elle a identifiés pendant son apprentissage. Ces résultats, que l’on appelle contenus, peuvent être des textes, des images, de la musique ou du code informatique.

L’IA apprend les règles en analysant des milliers de textes, images ou morceaux de musique (data set). Elle étudie la manière dont ils sont arrangés et détecte des motifs récurrents qu’elle utilise ensuite pour générer de nouveaux contenus en fonction d’une requête (prompt).

Les contenus générés par l’IA sont des recompositions statistiques de tout ce qui a été appris. Ils ont du sens parce qu’ils respectent les règles grammaticales, visuelles ou musicales extraites des data sets d’entraînement. Ces règles sont mémorisées sous forme d’un Large Language Model (LLM, voir ci-dessous). Cela permet, entre autres, de synthétiser des informations ou de proposer des contenus originaux.

Plusieurs entreprises sont actuellement des actrices majeures dans le domaine de l’IA. Leurs outils, accessibles en ligne, souvent gratuitement, sont actuellement les plus utilisés.

Microsoft Research

Créé en 1991 avec un focus sur les calculs d’ordinateur, la filiale s’investit dans l’IA dans les années 2010 avec divers rachats et possède maintenant 20% des brevets. Les innovations sont régulièrement ajoutées à ses produits (i.e. Bing, Holo Lens, Cortana, 365, Azure, etc.). En 2016, la division Microsoft Research AI est créée et LinkedIn est racheté pour alimenter de données ses modèles. Le partenariat en 2019 avec Open AI (i.e. ressources cloud) a été crucial pour le développement des modèles GPT.

- En 2023, Microsoft publie Copilot, un assistant IA qui s’intègre à tous ses services.

IBM

Pionnière, notamment avec DeepBlue qui bat le champion d’échecs Kasparov en 1996. En 2011, le programme Watson fait sensation en remportant le jeu télévisé Jeopardy! ce qui nécessite de comprendre l’énoncé, d’utiliser le buzzer et de répondre vocalement. Après un élargissement à Internet, l’usage est restreint, le constat ayant été fait qu’il lisait Wikipedia et utilisait régulièrement le mot bullshit dans ses réponses.

- Watson est monétisé en 2012 pour la santé, la finance et la recherche. En 2022, considéré comme un échec, le programme est vendu à un fonds d’investissement.

DeepMind (Google)

Créée en 2010, DeepMind est acquise en 2014 par Google pour devenir sa filiale IA. Ses modèles s’inspirent des neurosciences pour développer des algorithmes d’apprentissage. DeepMind se concentre sur les systèmes capables de jouer à des jeux. AlphaGo a été le premier à battre le champion du monde de go en 2017. À la suite de GPT-3, Google panique et publie rapidement son prototype d’agent conversationnel.

- L’outil Bard est vite publié avec le modèle LaMDA, rapidement changé pour PaLM2, avant d’être remplacé par Gemini.

Meta AI

Créé en 2013, Facebook Artificial Intelligence Research (FAIR) publie PyTorch en 2017, un catalogue open source de modèles de machine learning (i.e. utilisés par Tesla ou Uber). FAIR est rebaptisé Meta AI après la réorganisation de Facebook et, en 2023, publie son modèle de langage Llama. Le modèle est initialement accessible sur demande aux chercheurs et chercheuses pour un usage non commercial avant d’être fuité un mois plus tard.

- Llama 2 est une famille de modèles de langage open source. Meta n’a pas d’outil accessible publiquement.

OpenAI

Fondée en 2015 en association à but non lucratif, OpenAI devient une entreprise à but lucratif en 2019 et établit un partenariat majeur avec Microsoft. Elle développe GPT-3, un modèle de langage, en 2020 et annonce DALL-E pour la génération d’images en 2021. En 2022, GPT-3 est accessible en ligne, marquant un tournant majeur. Grâce aux investissements de Microsoft, GPT-4 est publié en 2023.

- L’outil ChatGPT repose sur GPT-4, un modèle puissant capable de traiter du texte et des images et de faire une recherche sur Internet en direct.

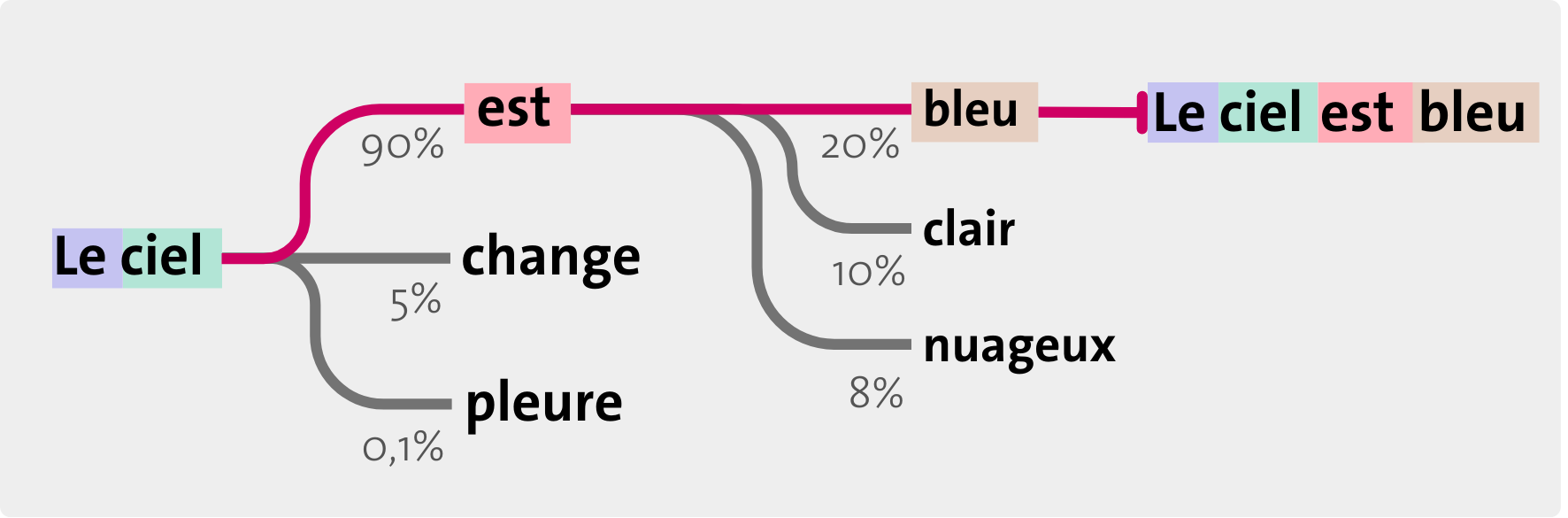

Un LLM est large, car il possède énormément de paramètres (de l’ordre de plusieurs milliards), qui sont autant de pièces d’information. C’est un modèle, car il s’agit d’un réseau de neurones entraîné sur une grande quantité de textes pour produire des tâches non spécifiques. Il est linguistique, car il reproduit la syntaxe et la sémantique du langage naturel humain en prédisant la suite probable pour une certaine entrée. Cela lui permet également d’avoir une «connaissance» générale sur la base des textes d’entraînement.

Les outils d’IA génératives sont alimentés par d’immenses quantités de données pour entraîner les algorithmes à l’origine des modèles de fonctionnement. Ces données peuvent avoir une origine variée:

- Elles sont collectées dans les contenus disponibles en ligne.

- Les requêtes et leurs réponses servent aussi à alimenter les modèles et à les améliorer.

À la suite des requêtes formulées par les utilisateurs/trices, ces outils génèrent davantage de données à partir de cet ensemble initial. Dès lors, les données et leur qualité apparaissent comme des éléments cruciaux, constituant la matière première dans le fonctionnement et l’usage des IA génératives.

Si la donnée est un objet possédant une grande valeur pour les outils, elle comporte également des risques d’utilisation.

- La donnée produite est faillible, avec des conséquences pour la vérification de l’information et sa transparence.

- La donnée insérée possède une sensibilité dont découlent des enjeux de sécurité, de protection de la vie privée, de propriété intellectuelle, etc.

L’IA générative nous donne l’illusion du contrôle. L’outil reste maître d’énormément de paramètres que nous ne comprenons pas ou ne maîtrisons pas et il est délicat d’institutionnaliser son usage. Une étude récente (Dell’Acqua et al., 2023) évoque l’idée d’une frontière «dentelée» ou «irrégulière» pour se référer aux limites imprévisibles de l’IA générative. Non linéaire, incohérente, cette limite rend l’outil ambivalent. Il peut soit améliorer, soit entraver la performance d’une tâche. Par exemple, il produit des textes complexes, comme des poèmes, mais peine à donner une liste de mots commençant par une même lettre.

L’erreur serait d’anthropomorphiser l’IA générative comme un assistant dont les erreurs et bizarreries seraient dues à un manque d’intelligence ou un atypisme.

Il s’agit d’un objet entièrement nouveau et nous ne pouvons pas, contrairement aux individus, extrapoler sur le niveau de compétence général à partir de quelques tâches, car il ne repose pas sur un ensemble de ressources cognitives corrélées ou transversales. Nous n’avons pas le recul pour en définir les contours.

Un enjeu particulier pour l’UNIGE a trait au droit des personnes, notamment en matière de données personnelles, qui n’est pas traité par le règlement de l’Université ou par une directive et ne peut l’être en raison de sa complexité. La décision de fournir néanmoins des recommandations s’appuie sur le risque dommageable pour l’institution et les individus de ne pas accompagner l’usage d’IA génératives dont les outils, approuvés ou non, sont tout de même accessibles.